MEGA Fauxpas: GoogleBot vs. BingBot

Zitat von klwild am 12. Mai 2024, 15:23 UhrMEGA Fauxpas: GoogleBot vs. BingBot

Was, wenn Google und Microsoft nicht so funktionieren, wie sie sollten?

Google mit der «Google Search Console» und Microsoft Bing mit dem «Bing Webmaster Tool» sind die bekanntesten, erfolgreichsten und lukrativsten Suchmaschinen bzw. SEO Tools, die es gibt und versprechen die Klickrate massiv auf Webseiten erhöhen.

Ich schreibe diesen Beitrag um mehr Leser und Knowhow Träger zu erreichen und eine Antwort auf dieses Problem zu bekommen. Die geballte Menge von Google sollte mir helfen. Ich werde, auch wenn es sinnlos ist, Werbung in Facebook und Instagram schalten, um eine Antwort zu bekommen.

Ich habe mehrere Webseiten in der Google Search Console aktiv (WordPress und phpBB) wo alles einwandfrei mit Indexierung, dem Crawling und der Anzahl Einträge richtig ist und funktioniert.

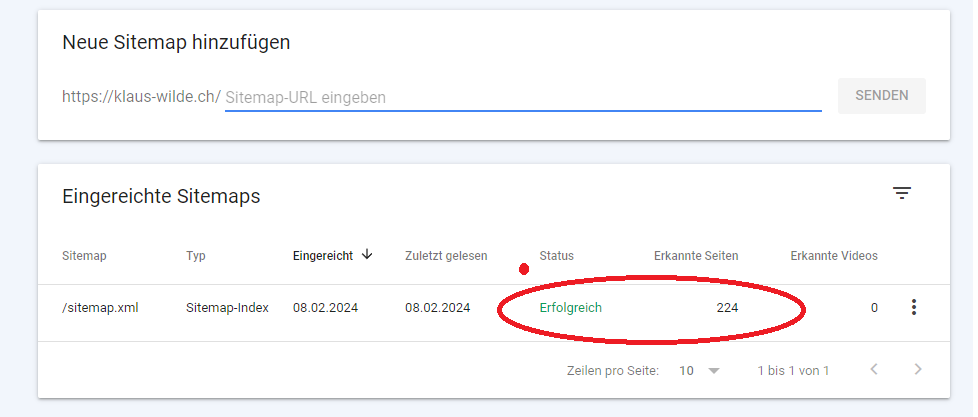

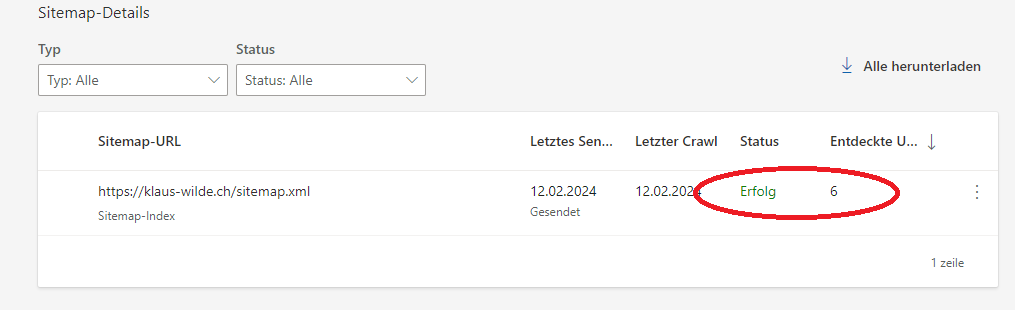

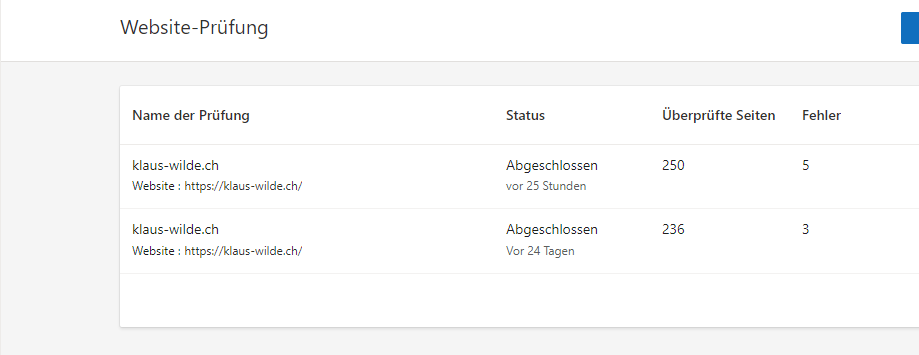

Alle Webseiten wurden dann in das Microsoft Bing Webmaster Tool von Google importiert. Der direkte Import ging nicht und der Import über Google war einfacher, welches aber kein Unterschied machen sollte.In den zwei Screenshots stellt sich das Phänomen wie zu sehen so dar!

In der Google Search Console ist die Anzahl gefundener Einträge richtig, im Bing Webmaster Tool werden extrem weniger Einträge gefunden, die indexiert werden können. Die robots.txt wird auch mal gefunden und mal nicht!

Das Ganze zeigt sich nun sodass ich bei Bing mit extrem weniger Beiträgen in der Websuche (SEO) gefunden werden kann, darum auch viel weniger Google AdSense Klicks bekomme und der Umsatz gänzlich gegen null geht.

Die Kontakte in Foren, 1st und 2nd-Level-Support gehen in unermessliche und jeder schiebt die Schuld auf einen anderen zurück und einen grossen Aufwand bedeutet.

Fazit ist, dass der aktuelle Stand wie unverändert ist und es sogar weniger als sechs Einträge angezeigt werden und niemand sich dafür zuständig fühlt.

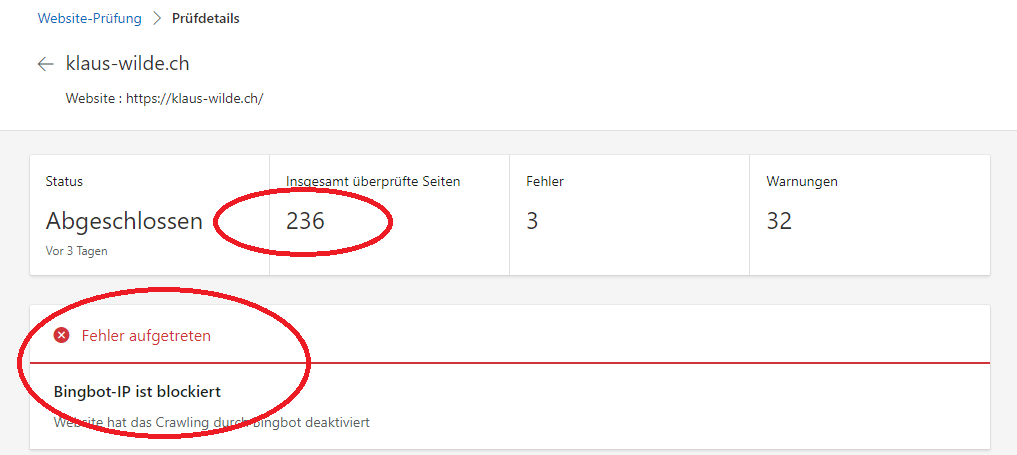

Der Hoster schreibt auch das der Crawler NUR auf die sitemap.xml und die robots.txt zugreift und daher ein Blocking an dieser Stelle nicht möglich ist. Er verweist auf die «Web Application Firewall» (WAF) und diese die Seite blockiert, was mir nichts sagt, dass der Teil beim Hoster liegt.

Im access.log und im error.log waren keine serverseitigen Zugriffe und Fehler zu finden, was den Hoster wieder ausschliesst.Ebenfalls komisch kommt mir vor das die robots.txt vom BING Webmaster Tool mal gelesen wird und mal nicht, auch ist der Inhalt immer wieder unterschiedlich. Auch die sitempap.xml wird mal erfolgreich eingelesen, nur mit 6 Einträgen, und mal nicht, obwohl die sitemap.xml immer die gleiche ist.

… und jetzt geht nichts mehr!

MEGA Fauxpas: GoogleBot vs. BingBot

Was, wenn Google und Microsoft nicht so funktionieren, wie sie sollten?

Google mit der «Google Search Console» und Microsoft Bing mit dem «Bing Webmaster Tool» sind die bekanntesten, erfolgreichsten und lukrativsten Suchmaschinen bzw. SEO Tools, die es gibt und versprechen die Klickrate massiv auf Webseiten erhöhen.

Ich schreibe diesen Beitrag um mehr Leser und Knowhow Träger zu erreichen und eine Antwort auf dieses Problem zu bekommen. Die geballte Menge von Google sollte mir helfen. Ich werde, auch wenn es sinnlos ist, Werbung in Facebook und Instagram schalten, um eine Antwort zu bekommen.

Ich habe mehrere Webseiten in der Google Search Console aktiv (WordPress und phpBB) wo alles einwandfrei mit Indexierung, dem Crawling und der Anzahl Einträge richtig ist und funktioniert.

Ich habe mehrere Webseiten in der Google Search Console aktiv (WordPress und phpBB) wo alles einwandfrei mit Indexierung, dem Crawling und der Anzahl Einträge richtig ist und funktioniert.

Alle Webseiten wurden dann in das Microsoft Bing Webmaster Tool von Google importiert. Der direkte Import ging nicht und der Import über Google war einfacher, welches aber kein Unterschied machen sollte.

In den zwei Screenshots stellt sich das Phänomen wie zu sehen so dar!

In der Google Search Console ist die Anzahl gefundener Einträge richtig, im Bing Webmaster Tool werden extrem weniger Einträge gefunden, die indexiert werden können. Die robots.txt wird auch mal gefunden und mal nicht!

Das Ganze zeigt sich nun sodass ich bei Bing mit extrem weniger Beiträgen in der Websuche (SEO) gefunden werden kann, darum auch viel weniger Google AdSense Klicks bekomme und der Umsatz gänzlich gegen null geht.

Die Kontakte in Foren, 1st und 2nd-Level-Support gehen in unermessliche und jeder schiebt die Schuld auf einen anderen zurück und einen grossen Aufwand bedeutet.

Fazit ist, dass der aktuelle Stand wie unverändert ist und es sogar weniger als sechs Einträge angezeigt werden und niemand sich dafür zuständig fühlt.

Der Hoster schreibt auch das der Crawler NUR auf die sitemap.xml und die robots.txt zugreift und daher ein Blocking an dieser Stelle nicht möglich ist. Er verweist auf die «Web Application Firewall» (WAF) und diese die Seite blockiert, was mir nichts sagt, dass der Teil beim Hoster liegt.

Im access.log und im error.log waren keine serverseitigen Zugriffe und Fehler zu finden, was den Hoster wieder ausschliesst.

Ebenfalls komisch kommt mir vor das die robots.txt vom BING Webmaster Tool mal gelesen wird und mal nicht, auch ist der Inhalt immer wieder unterschiedlich. Auch die sitempap.xml wird mal erfolgreich eingelesen, nur mit 6 Einträgen, und mal nicht, obwohl die sitemap.xml immer die gleiche ist.

… und jetzt geht nichts mehr!